- Meteorologie bietet sich als Testfeld für KI an

- Überlegenheit bei der Vorhersage von Extremwetterlagen

- Modelle für langfristige Prognosen werden stabiler und zuverlässiger laufen

- Dank KI alle 15 Minuten sehen, was passieren soll

- Zur Auswertung auch in Zukunft Meteorologen für präzise Wettervorhersage benötigt

- Wettervorhersage für Frachter

- Und was bringt KI den Wassersportlern?

- Konventionelle und KI-generierte Wettervorhersage im Vergleich

- Wie zuverlässig sind die alten und neuen Wettervorhersage-Modelle?

Künstliche Intelligenz (KI) oder auf Englisch Artificial Intelligence, ist derzeit in aller Munde, ob es Bilder, Videos, Musik oder andere Dinge sind. Bei allem wird gerade versucht, den Computer zu trainieren, um Ergebnisse zu bekommen, die besser sind, als die bislang erzielten, und die uns das Leben insgesamt auch leichter machen oder zumindest Arbeitsabläufe effizienter gestalten sollen.

Prominentestes Beispiel ist Chat GPT. Mittlerweile in der vierten Version, soll dieses Software-Tool nicht nur Texte ausspucken, sondern auch echte Konversationen führen können. In der Meteorologie wird KI ebenfalls eingesetzt. Meine Kollegen aus der IT-Abteilung nutzen sie bereits gern und regelmäßig, um damit Programmier-Codes zu untersuchen, zu generieren und auch zu verbessern. Und das funktioniert wunderbar!

Computer werden also mittels vorhandenen Wissens angelernt. Gibt es eine spezifische Anfrage, die sie vielleicht bereits kennt, schätzt die Maschine ab, welche Antwort wohl am wahrscheinlichsten ist. Oft passen die Resultate schon recht gut beziehungsweise sie werden von Anfrage zu Anfrage immer besser.

Mehr zum Thema Wettervorhersage:

Wenn es um eine Abschätzung von Wahrscheinlichkeiten geht, dann sind wir beinahe zwangsläufig auch in der Wettervorhersage. Hier wird seit Langem mittels verschiedener Modelle und vieler Einzelläufe abgeschätzt, welches Wetter sich in den kommenden Tagen einstellen wird. Ein sehr chaotisches System, das manchmal über zehn Tage hinweg, mitunter allerdings für nicht länger als 24 Stunden exakte Vorhersagen auszuspucken in der Lage ist.

Meteorologie bietet sich als Testfeld für KI an

Wettermuster wiederholen sich grundsätzlich und folgen vornehmlich atmosphärischen Regeln der Thermodynamik. Das Grundgerüst steht also. Das dachten sich unter anderem auch Google und das European Centre for Medium-Range Weather Forecasts (ECMWF), zu Deutsch das Europäische Zentrum für mittelfristige Wettervorhersage.

Google hat die für KI-Berechnungen erforderliche Infrastruktur in Form von Großrechnern, das ECMWF verfügt über Unmengen von Meteodaten. In Kombination entstand das Wettermodell GraphCast. Dieses bisher noch experimentelle Modell wurde mit sogenannten Re-Analyse-Daten gefüttert. Man hat also Messwerte mit Modelldaten gemixt, um so in den vergangenen Jahrzehnten auf die weltweiten Großwetterlagen zu kommen. Denn bis vor etwa 30 Jahren war das Messnetz noch nicht so dicht wie heute.

Auf diese Weise hat man die Wetterlage noch mal rückwärts nachgerechnet. Das GraphCast-Modell wurde dann mit dem weltweiten Wetter der Jahre 1979 bis 2017 gefüttert. Es hat gelernt, wie sich Meteo-Muster verhalten und welches Wetter sich daraus an den verschiedensten Orten der Welt für die Folgetage ergibt.

Zum Start einer Wettervorhersageberechnung braucht es in der Tat lediglich die Muster der globalen Druckverteilungen der vorangegangenen sechs Stunden sowie die aktuelle Lage. Zusammen mit dem Erlernten reicht das aus, um eine Prognose für die nachfolgenden Stunden zu erhalten.

Eine Pressemitteilung von Google hat dann aber die Fachwelt elektrisiert. Zum einen, weil das KI-generierte Modell eine Trefferquote von über 90 Prozent aufweist. Viel mehr noch waren wir Meteorologen von den Socken, da weniger als eine Minute Rechenzeit erforderlich ist, um eine solch verlässliche Vorhersage für die nächsten zehn Tage zu erstellen! Zum Vergleich: Die bisherigen operationellen Wettermodelle brauchen rund vier bis sechs Stunden, bis das Ergebnis vorliegt.

Überlegenheit bei der Vorhersage von Extremwetterlagen

Wie geht das? Nun, beim ECMWF-Modell werden 52 Einzelläufe gleichzeitig gestartet, und zwar jeder Lauf mit kleinen Änderungen in den Anfangsbedingungen. Nach bis zu sechs Stunden wird dann eine Abschätzung gemacht. Die Linien, die am dichtesten dran sind, zeigen auch den wahrscheinlichsten Weg der Wettersysteme der kommenden Tage. Das, was man sich zum Beispiel bei Windy als ECMWF- Modell anschauen kann, ist also nichts anderes als das wahrscheinlichste Ergebnis von 52 Einzelmodellberechnungen.

Gerade bei Ortsvorhersagen kann man sich auch alle 52 Einzelvorhersagen anzeigen lassen. Da kann dann schon mal eine Temperatur für zum Beispiel Hamburg von 30 Grad beim einen Lauf herauskommen, während ein anderer nur 15 Grad für denselben Tag prognostiziert. Alle weiteren Läufe liegen dazwischen, womit die Wahrscheinlichkeit hoch ist, dass es eher um die 20 Grad warm wird.

Es ist mittlerweile sogar möglich, sich nicht nur für einen bestimmten Standort, sondern selbst für große Regionen die Ergebnisse der Einzelläufe anzuschauen. Somit hätte man mit nur einem einzigen Wettermodell 52 verschiedene Wetterkarten vorliegen – aus denen man sich dann nur noch die wahrscheinlichste heraussuchen muss.

Zugegeben, das klingt alles ein wenig kompliziert, und darum wird auch die lange Rechenzeit benötigt. GraphCast wurde daher gegen dieses ECMWF-Modell getestet – und damit gegen das bisher zuverlässigste. Hinsichtlich der Genauigkeit bei den Parametern Wind, Temperatur und Luftdruck war es sofort überlegen. Aber offenbar auch bei der Vorhersage von Extremwetterlagen, obwohl es hierauf noch gar nicht trainiert worden war!

Allerdings: Es wurden zwei relativ grobe Wettermodelle miteinander verglichen. GraphCast wurde mit einer Gitterweite von 28 mal 28 Kilometern betrieben und mit exakt dieser Gitterweite auch das ECMWF-Modell herangezogen. Das bedeutet, nur alle 28 Kilometer auf geografischer Länge und ebenso nur alle 28 Kilometer auf geografischer Breite gibt es Punkte, die Ergebnisse ausspucken. Damit lassen sich gut die Zugbahnen und Entwicklungen von Hochs und Tiefs vorhersagen, aber nicht zum Beispiel lokale Phänomene wie Seewind.

Modelle für langfristige Prognosen werden stabiler und zuverlässiger laufen

Es geht jedoch heutzutage durchaus schon viel kleinräumiger. Das ICOND2-Modell des Deutschen Wetterdienstes hat eine Auflösung von 2,1 Kilometern. Das ist bisher noch ein großer Vorsprung vor der KI. Sollten GraphCast oder andere KI-Modelle allerdings auch in diese Auflösungssphären vorstoßen oder sogar noch kleinräumiger werden, sind damit in Zukunft sicher auch regionalere Ereignisse wie Gewitter und vielleicht Tornados besser als derzeit vorhersagbar.

Damit nicht genug, hat Google zusätzlich zum GraphCast Erweiterungen mitentwickelt wie etwa NeuralGCM. Das ist ein Modell, das die KI und die traditionelle physikbasierte Methode der Wettervorhersage verbindet: Großräumige atmosphärische Phänomene werden simuliert und gleichzeitig mit Hilfe neuronaler Netzwerke kleinere Merkmale wie Wolken und Niederschlag genau abgeschätzt. Dies dürfte dazu führen, dass die Modelle für langfristige Prognosen stabiler und zuverlässiger laufen.

Ebenso hat der Softwaregigant ein weiteres Hilfsmittel mit der KI verknüpft: Scalable Ensemble Envelope Diffusion Sampler (SEEDS) heißt die Methode, die wie oben angesprochen ebenfalls viele verschiedene Vorhersageläufe durchrechnen lässt, um eine Abschätzung zu ermöglichen, welches Szenario am wahrscheinlichsten eintrifft. Dies dient vor allem dazu, Extremwetterereignisse frühzeitiger erkennen zu können.

Grundsätzlich ist das zwar keine neue Methode, doch vor allem aufgrund der KI werden auch diese vielen Vorhersagevarianten in nur noch einem Bruchteil der bisherigen Rechenzeit generiert. Wer sich selbst einmal einen Eindruck von der jetzt schon erzielten Genauigkeit des GraphCast-Modells verschaffen möchte, kann dies übrigens problemlos tun. Die täglichen Wetterkarten des Projekts stehen auf der Seite vom ECMWF und können mit denen des operationellen Modells verglichen werden.

Dank KI alle 15 Minuten sehen, was passieren soll

Sollten KI-Anwendungen in der Wetterszene weiteren Einzug halten und die bisherigen numerischen Modelle ablösen – und das werden sie! –, dann hätte das enorme Folgen. Besonders die eingesparte Rechenkapazität stünde für andere Anwendungen zur Verfügung. So hat zum Beispiel der französische Wetterdienst ein neues Modell, Arome PI, auf den Markt gebracht, das neben der aktuellen Wetterlage nicht nur stündlich, sondern 15-minütig nach vorn rechnet. Es soll also immer genauer und feiner werden, um zu sehen, wohin beispielsweise Regenschauer ziehen und ob und vor allem, wo sich neue bilden.

Bisher gleicht das Entstehen von Schauerzellen und damit auch gegebenenfalls von Starkregen mit Überflutungen einer Lotterie: Ich vergleiche die Vorhersage, wo der nächste Schauer auftritt, immer mit kochendem Wasser im Topf. Auch hier kann keiner sagen, wo die nächsten Blasen aufsteigen.

Man kann sich also jetzt schon durch die Wetterkarten klicken und alle 15 Minuten sehen, was passieren soll – in der Hoffnung, dass man damit noch näher an die Realität herankommt. Gerade bei Unwetterwarnungen wird dies ein extrem wichtiges Werkzeug werden.

Auch in China ist man nicht untätig in Sachen KI und Wetter. Das Unternehmen Huawei Cloud versucht ein eigenes Modell namens Pangu- Weather für siebentägige Vorhersagen zu trainieren. An der Uni in Peking setzt man dagegen auf kleinräumige Niederschlagsvorhersagen für nur drei Stunden im Voraus mittels des KI-Modells FourCastNet. Auch hier kommt den Modellen die Statistik der letzten Jahre zugute.

Doch das hat auch seine Tücken. Gerade bei Extremwetterlagen, wie wir sie weltweit immer häufiger sehen. Solche Ereignisse sind noch nicht Teil der Statistik. Auch Hurrikans und Taifune mit den Kategorien 3 bis 5, Major Hurricanes oder Monster-Taifune genannt, sind in den Daten bisher noch zu selten vertreten, als dass sie zuverlässig vorherzusagen wären. Dazu kommt, dass die physikalischen Gleichungen, die von den bisher verwendeten Modellen genutzt werden, sich auch gegenseitig bedingen. Bestimmte Prozesse wie Wolken, Strahlung und Turbulenzen sind also voneinander abhängig und schwer zu modellieren. Das zu berücksichtigen ist nicht einfach, besonders nicht bei einer Modellauflösung von ebenfalls 28 mal 28 Kilometern.

Zur Auswertung auch in Zukunft Meteorologen für präzise Wettervorhersage benötigt

Daher sind die Ansätze sehr unterschiedlich. Pangu-Weather hat nur Beobachtungsdaten als Grundlage verwendet. FourCastNet dagegen, das viel kleinräumiger arbeitet, nutzt neben der KI auch die physikalischen Gleichungen und kombiniert beides. Pangu-Weather soll 10.000-mal schneller rechnen als vergleichbare numerische Modelle. Es ist daher für die mittelfristige Vorhersage geeignet, trifft aber keine Aussagen über den Niederschlag. Hier käme das andere Modell ins Spiel, das, je dichter man an das Wetterereignis kommt, eine genauere Vorhersage über die Regenmenge zulässt.

Dass wir hier schon von zwei Modellen reden, die bei unterschiedlichen Anwendungsfällen zum Einsatz kommen, spricht dafür, dass es auch in Zukunft für eine saubere Einschätzung der Lage ohne den Meteorologen nicht gehen wird. Per se ist KI so neu gar nicht, und ein gewisses Maß nutzen Segler bereits schon seit einigen Jahren. Insbesondere wenn es ums Routing geht in Kombination mit Wettervorhersagen.

Hierbei wird mit Software-Tools wie „Expedition“ oder „Adrena“ auf Basis der Polardiagramme des eigenen Bootes gearbeitet. Am Ende spucken die Programme unter Berücksichtigung von Wind und Wetter die wahrscheinlich beste beziehungsweise schnellste Route aus.

Dabei setzen sie das virtuelle Schiff Stunde um Stunde weiter und schauen sich an, welcher Wind zu diesem Zeitpunkt am dann erreichten Ort vorherrscht. Das Polardiagramm zeigt, bei welcher Windrichtung und -stärke das Boot am schnellsten segelt. Somit werden Zeitschritt für Zeitschritt sogenannte Isochronen ausgegeben – mit dem entsprechenden Kursvorschlag.

Nichts anderes machen Profisegler mehrmals täglich, wenn neue Wetterdaten einlaufen. Auch Strömungsdaten lassen sich mit einbeziehen. Damit schätzt die Software den bestmöglichen Kurs ab. Diese Berechnungen brauchen aber Zeit. Vor allem, wenn man viele Daten seines Schiffs einpflegt.

Wettervorhersage für Frachter

Genutzt wird das Ganze ebenfalls schon länger in der Berufsschifffahrt. Die KI soll möglichst schnell und ohne großen Einsatz von menschlichen Wetterroutern die optimale und sicherste Route für Frachter oder Tanker anzeigen. Dabei werden nicht zuletzt mit Hilfe von Wind, Welle und Strömung Sprit und somit Kosten eingespart. Gleichzeitig vermeidet man, in Sturm zu geraten und gegebenenfalls wertvolle Containerfracht zu verlieren.

Nicht zuletzt dank Starlink-Internet an Bord werden diese Berechnungen auch nicht mehr auf dem Bordrechner durchgeführt, sondern auf externe Server ausgelagert. Dort liegen ja bereits die aktuellen und historischen Wetterdaten, wodurch die individuellen Berechnungen für ein bestimmtes Schiff noch zügiger erfolgen können.

So sieht also schon jetzt die Zukunft aus. Doch ganz ohne den Menschen mit seinem Fachwissen geht es dann doch noch nicht. Meine Kollegen und ich sind trotz all der jetzt schon vorhandenen technischen Möglichkeiten weiterhin Ansprechpartner Nummer eins für die Kapitäne, wenn sie Wetterlagen richtig abschätzen und die beste Route zum nächsten Zielhafen ausarbeiten wollen.

Und was bringt KI den Wassersportlern?

Mit großer Sicherheit werden künftig immer mehr Apps ein automatisiertes Routing erstellen können. Der Anwender tippt dann nur noch Start und Ziel ein, zum Beispiel von Kiel nach Rostock, und fügt den gewünschten Startzeitpunkt hinzu. Schon wird berechnet, welcher der beste Kurs bei den dann sehr wahrscheinlich gegebenen Wetterbedingungen ist.

Was ist die Konsequenz? Kommt zwangsläufig bald das autonome, von der KI gesteuerte und überwachte Boot fahren? Man darf gespannt sein. Sich komplett auf die Technik zu verlassen birgt allerdings Gefahren. Insbesondere, weil das Wettersystem derart komplex und chaotisch ist, dass niemals alles darin sauber von Modellen erfasst werden kann. Unsicherheiten bleiben. Insbesondere, wenn es um schwierige Wetterlagen geht, bei denen mehrere Modelle für eine verlässliche Vorhersage zurate gezogen werden müssen.

Auch hier seien einmal mehr die Extremwetterlagen genannt. Sie exakt einzuordnen wird gewiss noch eine ganze Zeit lang nicht ohne das Wissen und die langjährige Erfahrung von Meteo-Fachleuten möglich sein.

Und gerade bei den Routingtools, auf die sich viele schon jetzt gern verlassen, wissen die meisten nicht, dass dabei oft nur der Mittelwind berücksichtigt wird. Böen oder andere Unwetterparameter bleiben außen vor. Lädt man sich dann die Wetterdaten herunter, die beispielsweise nur eine zeitliche Auflösung von drei Stunden haben, sieht man eine aufziehende Unwetterlage vielleicht gar nicht.

Kenntnisse über die grundsätzliche Wetterentstehung und -entwicklung sind daher weiterhin unerlässlich – wie auch das saubere Arbeiten damit. Man sollte aber zudem wissen, wie man mit all diesen neuen, faszinierenden Tools umzugehen hat. Schließlich lässt sich die schnell fortschreitende technische Entwicklung nicht wegdiskutieren. Sie wird, mit der Absicht, Wettervorhersagen zu verbessern, die Welt zumindest in diesem Bereich zum Positiven verändern.

Ich selbst bin gespannt, wohin die Reise in den kommenden Jahren gehen wird – und möchte auf jeden Fall dabei sein.

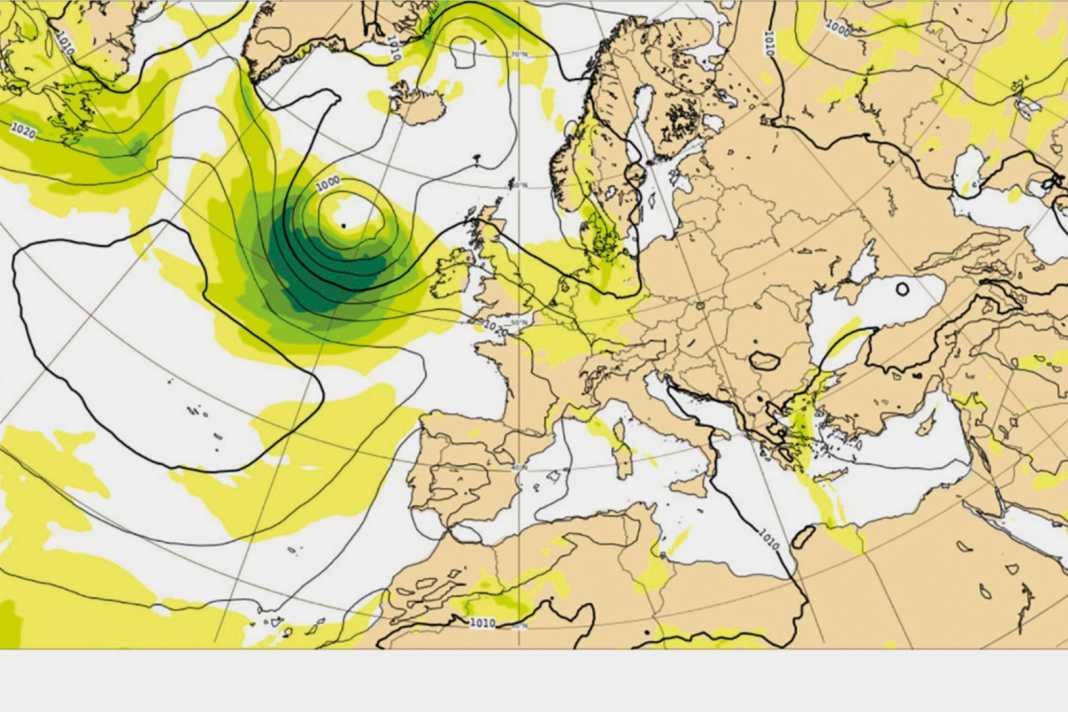

Konventionelle und KI-generierte Wettervorhersage im Vergleich

Unter charts.ecmwf.int lassen sich im Internet sämtliche Datenprodukte des europäischen Wettercenters ECMWF einsehen. Dort finden sich nicht nur die Modellvorhersagen des herkömmlichen operativen und numerischen Modells, das auch zum Beispiel in Windy.com oder andere private und kommerzielle Wetter-Apps eingeht. Sondern hier findet man – ganz unten auf der sehr vollen Seite – auch bereits die neuen KI-Modelle beziehungsweise die Ergebnisse, die sie ausspucken: Während es bei einer relativ kurzfristigen Vorhersage im Bereich von etwa 24 Stunden kaum nennenswerte Abweichungen gibt, fallen die Unterschiede bei einem längeren Vorhersagezeitraum doch deutlich aus.

Obenstehend beispielhaft die Wetterkarten basierend auf einer Zehn-Tages-Prognose für die Druckverteilung über Europa vom 31. Juli bis 10. August 2024: Während das numerische Modell ein sehr kräftiges Tief bereits vor der Küste Irlands sieht, prognostizieren auch die beiden KI-Modelle zwar die Bildung dieses Tiefs, aber noch deutlich verzögerter und vor allem viel weiter im Westen, mit dem Kern erst zwischen Neufundland und Grönland.

Wie zuverlässig sind die alten und neuen Wettervorhersage-Modelle?

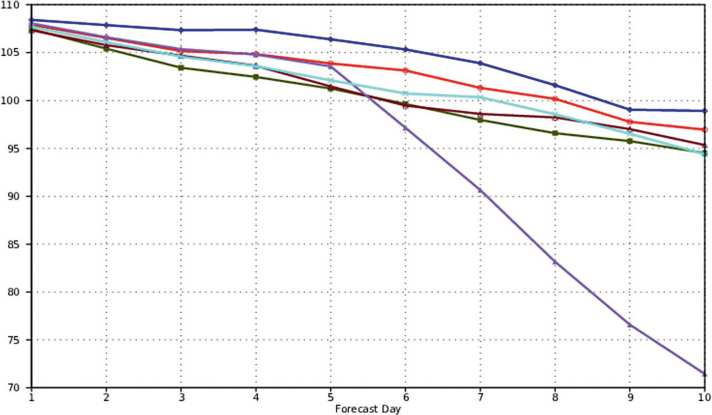

Die neuen KI-Modelle werden stetig mit den bisherigen verglichen. Auch deren Verhalten. Und so wird zum Beispiel die Modellaktivität untereinander beobachtet. Verlaufen die Graphen gleichmäßig, dann ist auch mit wenigen Überraschungen in der Vorhersage über einen Zeitraum von zehn Tagen zu rechnen. Einzig das FuXI (ein anderes KI-Modell) zeigt im Beispiel ab Tag fünf ein sehr chaotisches Verhalten. Alle anderen, die etablierten wie auch die neuen KI-Modelle, weisen hingegen einen entspannten Abfall in der Sicherheit der Prognosen auf. Dabei betrachtet man im Übrigen vor allem die 500-hPa-Werte, die in rund 5,5 Kilometer Höhe gemessen werden. Sie lassen am besten erkennen, wie Hochs und Tiefs sich auch bis zum Boden in den nächsten Tagen verhalten werden.

Dass die meisten KI-Modelle wie hier im Beispielfall ein ähnliches Verhalten wie die etablierten AIFS- und IFS-Modelle des ECMWF zeigen, sie sogar teils jetzt schon eine höhere Genauigkeit aufweisen und weniger fehleranfällig sind, ist schlicht erstaunlich.